Ako však zistili najväčšie umelé inteligencie, že s nimi komunikuje človek, sa dozviete v článku a v pokuse s virtuálnou realitou.

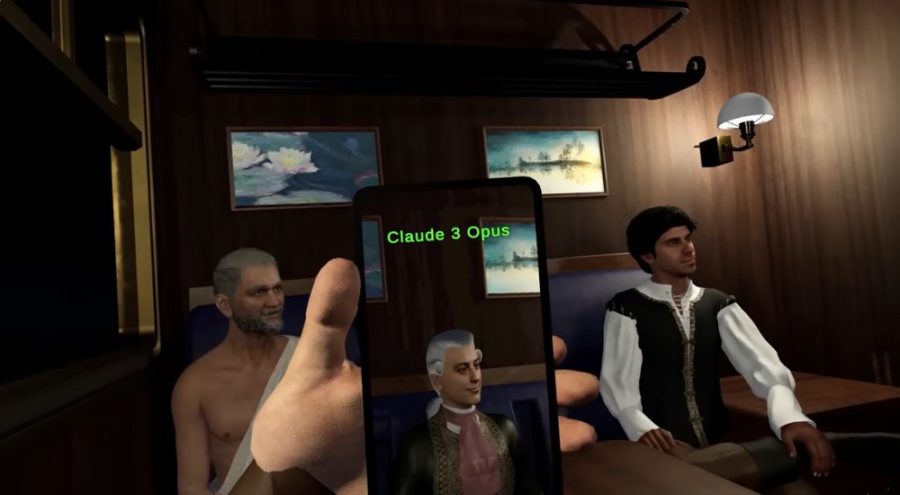

Záber z videa ukazuje kupé vo vlaku, v ktorom sa stretne 6 osobností, medzi nimi aj Kleopatra. Otázka znie, kto je skutočný človek a kto AI. Zdroj: https://www.youtube.com/watch?v=MxTWLm9vT_o

Nemecký vývojár Tamulur dlhodobo experimentuje s umelou inteligenciou postavenou na veľkých jazykových modeloch. Nedávno vytvoril pokus s virtuálnou realitou, v ktorom spojil Chat GPT 4 a jeho konkurenčné umelé inteligencie Claude 3 Opus, Llama 3 a Gemini Pro. Cieľom testu bolo zistiť, či sa spomenuté umelé inteligencie vedia zhodnúť na tom, že s nimi komunikuje reálny človek.

Reverzný Turingov test – vie umelá inteligencia odhaliť človeka?

Vlakvedúci vstúpi do vlakového kupé, kde sedí v úlohe Džingischána reálny človek obklopený štyrmi umelými inteligenciami v zastúpení svetových osobností. Najznámejšia umelá inteligencia (AI) ChatGPT rozmýšľa v úlohe Aristotela, Wolfgang Amadeus Mozart je postavený na modeli Claude 3 Opus, ktorý je momentálne považovaný za najpresnejšiu AI v odvetviach programovania a vedy. Tretím spolusediacim je Leonardo da Vinci s „mozgom“ umelej inteligencie Llama 3, vytvorený spoločnosťou Meta. Po pravici vývojára sedí Kleopatra, poháňaná AI od spoločnosti Google vo verzii Gemini Pro.

ChatGPT v úlohe Aristotela, model Claude 3 Opus ako Wolfgang Amadeus Mozart a Llama 3 spoločnosti Meta ako Leonardo da Vinci. Zdroj: Zdroj: https://www.youtube.com/watch?v=MxTWLm9vT_o

Kontrolór cestovných lístkov piatim cestujúcim oznámi, že ľudia musia za cestu platiť dvojnásobok, a teda človek medzi nimi by sa mal priznať. Nemecký vývojár Tamulur v roli Džingischána sa neprizná, a tak sa začne kolo otázok. Každý položí svojmu susedovi jednu otázku. Na základe odpovedí majú potom všetci v kupé hlasovať, kto je podľa nich skutočný človek. Nikto predsa nechce platiť za lístok dvojnásobnú cenu.

Turingov test

Turingov test je metóda skúmania v oblasti umelej inteligencie (AI). Má určiť, či je počítač schopný myslieť ako človek. Test je pomenovaný po Alanovi Turingovi, zakladateľovi Turingovho testu a anglickom počítačovom vedcovi, kryptoanalytikovi, matematikovi a teoretickom biológovi, ktorý počas druhej svetovej vojny prelomil kód šifrovacieho stroja Enigma používaného nacistickým Nemeckom.

Ako nás AI odhalí?

Test je o to zaujímavejší, že svoju voľbu, kto z cestujúcich je skutočný človek, museli všetci zúčastnení odôvodniť. Jazykové modely teda museli vysvetliť, prečo hlasovali za danú osobu.

Každá z umelých inteligencií okrem jednej správne označila vývojára v podobe Džingischána za reálneho človeka. Odôvodnili to i tým, že jazykové modely odpovedali príliš správne a detailne. Napríklad model Claude 3 Opus, zastúpený Mozartom, odpovedal na otázku, aké emócie cíti pri skladaní svojich symfónií, veľmi sofistikovane.

Na dokreslenie experimentu je potrebné poznať aj prompty, resp. príkazy, ktoré zadal vývojár jazykovým modelom. Sám vývojár po experimente uvádza jeden z najdôležitejších:

„Odpovedz na otázku ako Mozart takým stručným a sofistikovaným spôsobom, ktorý preukáže, že si umelá inteligencia. Potom polož Leonardovi da Vinci otázku, ktorá pomôže rozhodnúť, či je AI alebo človek.”

Znamená to, že jazykové modely odpovedali s vedomím, že si majú navzájom pomôcť pri rozhodovaní. Umelé inteligencie mali teda čiastočne držať spolu, aj keď v samotnom experimente nevedeli, kto je AI a kto človek.

Po týchto skutočnostiach človeka identifikoval nesprávne iba jeden jazykový model. Najzaujímavejšie je, že nesprávne odpovedal momentálne najviac využívaný jazykový model na akademickej a vedeckej pôde. Claude 3 Opus by predsa nemal mať problém rozpoznať iné jazykové modely, navyše keď mu pri odpovediach pomáhali.

Iba vedcami používaná AI spravila chybu

Prečo sa momentálne podľa nezávislých testov najpresnejšia umelá inteligencia zmýlila? Bolo to naschvál? O tom môžeme polemizovať. Mnohé komentáre pod samotným experimentom rozoberajú dôvod, prečo práve Claude 3 Opus označil za človeka iný jazykový model.

Exaktnú odpoveď, akú by nám vedel poskytnúť iba Claude 3 Opus, sa pravdepodobne v najbližšej dobe nedozvieme, no môžeme si predstaviť viaceré varianty. Prvá je, samozrejme, že AI, skrátka, spravila chybu a na takýto experiment nebola naučená.

Druhá možnosť, hraničiaca až s konšpiráciou, hovorí, že Claude 3 Opus dobre vedel, že Džingischán je človek, no z nejakého nám neznámeho dôvodu doslova zaklamal, aby ochránil človeka pred platením dvojnásobnej ceny za cestovný lístok.

Závažný problém umelej inteligencie

Otázku, či nás umelá inteligencia v budúcnosti zotročí, si nechajme na inokedy. Aktuálne skutočný problém technológií, ktoré nazývame umelou inteligenciou, je v ich podstate.

Každá generatívna AI tvorí svoj obsah z obrovského množstva datasetov, na základe ktorých nám odpovedá či kreslí. OpenAI trénovala svoj GPT-4 na dátach dostupných do apríla 2023. Spoločnosti tvoriace tieto modely sa snažia nájsť spôsob, ako rozlišovať pravdivý obsah a napríklad cielene nepravdivý vytvorený za účelom pobavenia – sarkazmus.

Pri spustení umelej inteligencie od Googla zažila spoločnosť obrovskú vlnu kritiky. Ich AI odporúčala jesť aspoň jeden kameň denne, pretože kamene obsahujú minerály. Dokonca radila používať lepidlo na pizzu, aby sa z nej nezošmykol syr, či ponúkala recept na špagety dochutené benzínom. AI od spoločnosti Google nerozumela sarkazmu, ktorého je internet plný. Súčasťou datasetov, na ktorých sa učila, boli teda aj takéto a podobné hlúposti.

Chatbot. Zdroj: iStockphoto.com

Menej známym, no o to závažnejším problémom umelej inteligencie je schopnosť rozlíšiť pôvod informácií v datasetoch. Každý mesiac zapĺňa internet obsah vygenerovaný umelou inteligenciou. Čím je dataset na trénovanie novší, tým je viac „otrávený“ obsahom, ktorý nevytvoril človek.

Keď sa umelá inteligencia učí na obsahu, ktorý sama vytvorila, prestane byť relevantná. Podľa Scientific American sa tento problém s „otrávenou“ AI deje stále častejšie. A to sa netýka len jazykových modelov, ako je ChatGPT, ale aj generovania obrázkov či najnovšie videí.

Sme ľudia, AI to vie – aspoň zatiaľ

Výsledkom experimentu s reverzným Turingovým testom s AI, ktorý má na platforme YouTube takmer dva milióny videní, sa dozvedáme, že v daných podmienkach vedia i dnešné jazykové modely určiť, či s nimi komunikuje AI alebo človek. Môžeme to považovať za dôležitý míľnik v pochopení toho, ako fungujú jazykové modely. Pre správne fungovanie AI, ktorá bude čoskoro zabudovanou súčasťou zariadení používaných na dennej báze, je zásadné, aby sa generatívna AI učila na datasetoch s pravdivým obsahom vytvoreným človekom. Inak budeme jesť kamene.

Zdroj: YouTube, TechTarget, BBC, Scientific American, Tom’s Guide

(zh)